Les différents types d’IA expliqués simplement.

Hey, êtes-vous prêt à découvrir ce qui pourrait bien redéfinir notre avenir ?

L'intelligence artificielle, ce domaine fascinant de l'informatique et des sciences cognitives, s'est construite progressivement autour de différentes approches méthodologiques et architectures techniques qui n'ont cessé d'évoluer et de se perfectionner au fil des décennies.

De l'IA symbolique aux réseaux de neurones profonds, chaque étape de son développement a apporté de nouvelles perspectives et capacités.

Allez, suivez le guide, on fait un tour de ce qui existe !

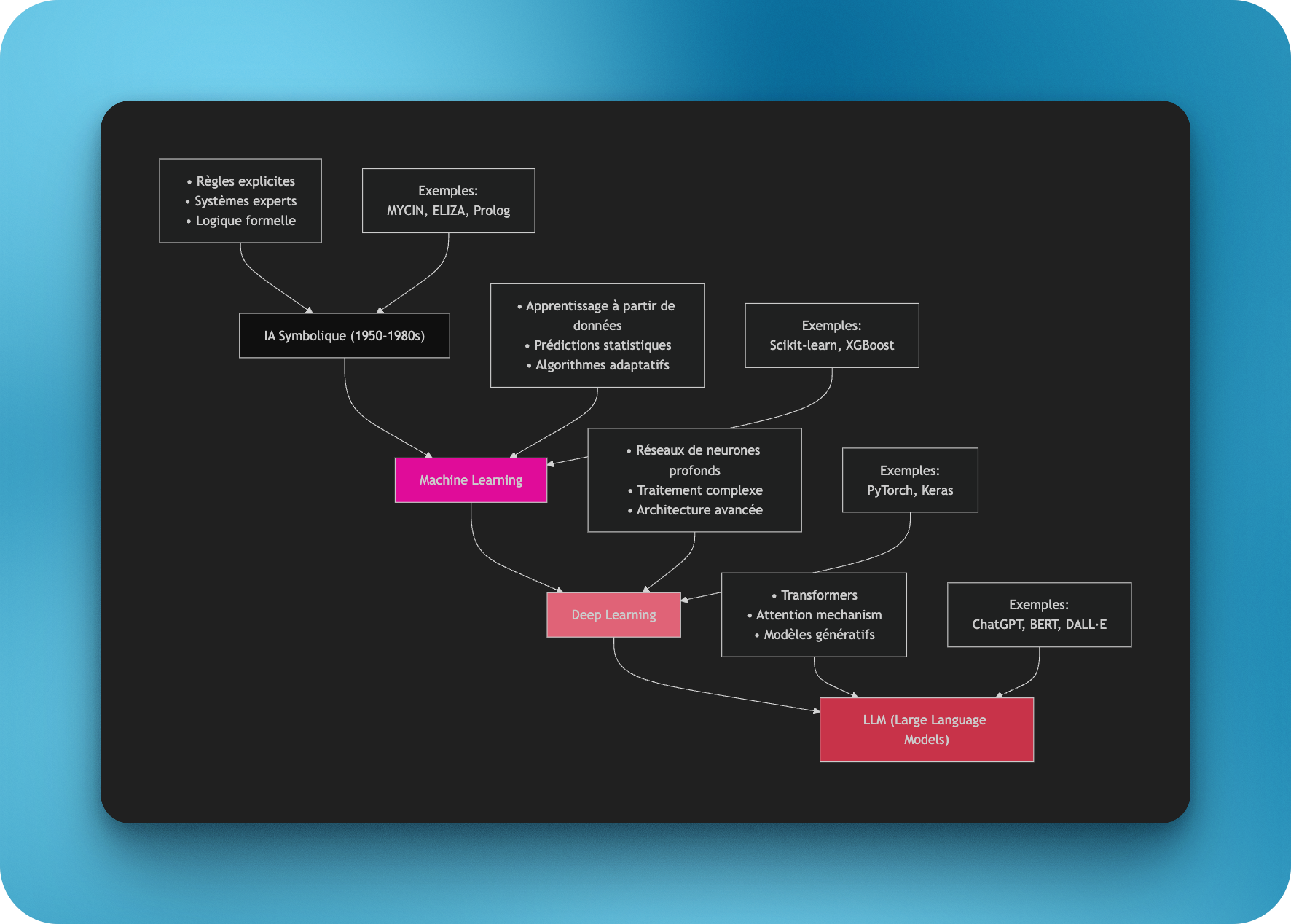

0. L'article est long. Un schéma, ça vous tente ?

Oui, parfois, j'écris trop. Alors voici une représentation rapide de l'évolution des IA de la naissance du concept aux applications du jour.

1. IA Symbolique (GOFAI - Good Old-Fashioned AI)

- Description : L’IA symbolique repose sur des règles explicites et des structures logiques définies par des humains.

- Applications :

- Systèmes experts en diagnostic médical (ex. : MYCIN dans les années 1970).

- Jeux comme les échecs (avant le Machine Learning).

- Planification et résolution de problèmes.

- Limitations :

- Rigidité face à des environnements dynamiques ou des données imprécises.

- Incapacité à gérer les incertitudes du monde réel.

2. Machine Learning (ML)

- Description : Les machines apprennent à partir de données pour faire des prédictions ou des classifications sans que les règles explicites soient définies à l’avance.

- Types :

- Apprentissage supervisé : basé sur des données étiquetées (ex. : distinguer des images de chats et de chiens).

- Apprentissage non supervisé : identifier des structures cachées dans des données non étiquetées (clustering, réduction de dimension).

- Apprentissage par renforcement : un agent apprend par essais et erreurs pour maximiser une récompense (utilisé dans AlphaGo).

- Exemples :

- Reconnaissance d’images.

- Prédictions dans des modèles financiers.

- Publicité ciblée.

- Limitations :

- Dépendance aux données disponibles.

- Sensibilité aux biais présents dans les données.

3. Deep Learning (DL)

- Description : Une sous-catégorie du Machine Learning qui utilise des réseaux de neurones profonds pour traiter des données complexes à grande échelle.

- Architectures principales :

- CNN (Convolutional Neural Networks) :

- Idéal pour les images et les vidéos.

- Exemples : déverrouillage facial, voitures autonomes, analyse d’imagerie médicale.

- RNN (Recurrent Neural Networks) :

- Optimisé pour les données séquentielles (texte, son).

- Exemples : sous-titrage automatique, traduction de texte, prévisions météo.

- Transformers et attention :

- Révolutionnent le traitement des séquences longues et complexes.

- Exemples : modèles de langage comme GPT, traduction de romans, génération d’images via DALL·E.

- CNN (Convolutional Neural Networks) :

- Applications :

- Traitement du langage naturel (NLP).

- Vision par ordinateur.

- IA générative (texte, images, sons).

- Limitations :

- Très gourmand en ressources (calcul et données).

- Fonctionnement en "boîte noire", difficile à interpréter.

Comparatif des trois types d’IA :

| Aspect | IA Symbolique | Machine Learning | Deep Learning |

|---|---|---|---|

| Base | Règles explicites | Modèles statistiques | Réseaux de neurones profonds |

| Données nécessaires | Faibles | Moyennes à élevées | Énormes volumes de données |

| Applications | Logique et diagnostic | Prédiction et classification | Vision, NLP, IA générative |

| Limitation | Rigidité | Sensibilité aux biais | Complexité et coût énergétique |

Résumé visuel des architectures principales (Deep Learning) :

| Architecture | Données idéales | Exemple concret |

|---|---|---|

| CNN | Images et vidéos | Déverrouillage facial, Voitures autonomes |

| RNN | Texte ou son séquentiel | Sous-titres, Traduction automatique |

| Transformers | Séquences longues et variées | GPT (chatbots), Traduction de livres, DALL·E |

En bref :

- IA Symbolique : conçue pour des tâches logiques précises, mais limitée face à des environnements imprévisibles.

- Machine Learning : permet aux systèmes d’apprendre et de s’adapter à partir de données.

- Deep Learning : la méthode actuelle la plus avancée pour des applications complexes, mais elle reste dépendante de ressources massives et est loin de l’intelligence humaine.

Les LLM : une spécialisation du Deep Learning

- Origine : les transformersLes LLM comme GPT (OpenAI), BERT (Google) ou LLaMA (Meta) utilisent l’architecture Transformer, introduite en 2017 dans le papier "Attention Is All You Need".

- Les Transformers utilisent un mécanisme d’attention qui leur permet de traiter efficacement de longues séquences de texte en mettant l'accent sur les mots les plus importants dans un contexte donné.

- Cela surpasse les limitations des RNN et améliore considérablement la compréhension des relations complexes dans un texte.

- Caractéristiques des LLM

- Entraînés sur d’énormes corpus de données textuelles : ils apprennent à prédire le mot suivant dans une phrase ou à compléter du texte.

- Taille massive : les LLM modernes ont des milliards de paramètres, ce qui leur permet de capturer des subtilités du langage et de répondre à des requêtes complexes.

- Applications :

- Génération de texte (GPT, ChatGPT).

- Résumé de documents (BERT, Pegasus).

- Traduction automatique (MarianMT).

- Recherche conversationnelle (Google Bard, Bing Chat).

Les LLM sont-ils "à part" ?

Non, mais ils représentent un changement d'échelle et d'application spécifique du Deep Learning. Voici pourquoi ils se distinguent :

- Taille et généralité : contrairement aux modèles classiques, les LLM sont des modèles généralistes qui peuvent être adaptés à une grande variété de tâches en langage naturel (NLP).

- Capacité émergente : à partir d’une certaine taille (nombre de paramètres), les LLM semblent développer des "compétences" inattendues, comme résoudre des équations simples ou écrire du code.

- IA générative : les LLM sont au cœur des systèmes d’IA générative qui produisent du contenu textuel, et parfois même du multimodal (texte + image).

Comment les LLM s’intègrent dans le panorama des IA ?

| Catégorie | Position des LLM |

|---|---|

| IA Symbolique | Non concernés. Trop spécialisés pour du raisonnement symbolique pur. |

| Machine Learning | S'appuient sur les principes d'apprentissage supervisé, mais à grande échelle. |

| Deep Learning | Directement issus des architectures avancées comme les Transformers. |

| Applications | Traitement du langage naturel (NLP), IA générative, assistants virtuels. |

Pourquoi sont-ils révolutionnaires ?

- Contextualisation avancée :Les LLM capturent les relations complexes entre les mots, phrases et paragraphes, ce qui leur permet de générer des réponses cohérentes et pertinentes.

- Flexibilité :Un LLM pré-entraîné peut être affiné (fine-tuning) pour des tâches spécifiques sans nécessiter un entraînement complet.

- Limites actuelles :

- Les LLM ne comprennent pas réellement le langage : ils prédisent statistiquement les mots les plus probables dans un contexte donné.

- Ils sont très coûteux à entraîner et à exécuter, consommant énormément de ressources (énergie, matériel).

- Sensibles aux biais dans leurs données d'entraînement.

Résumé rapide :

- Transformer (2017) → Modèle fondateur

- Base pour les LLM (attention multi-têtes, traitement parallèle des séquences).

- LLM (2018+) :

- GPT, BERT, T5, etc. → Génération, résumé, traduction, recherche conversationnelle.

- LLM aujourd’hui :

- Outils comme ChatGPT, Google Bard, et Bing Chat, utilisés pour révolutionner les interactions homme-machine.

Les LLM sont donc le sommet actuel du Deep Learning dans le domaine du traitement du langage naturel et des systèmes génératifs.

Quelques grands outils et services par type d’IA

1. IA Symbolique (GOFAI)

- MYCIN : Système expert médical des années 1970, conçu pour diagnostiquer les infections bactériennes.

- DENDRAL : Système expert en chimie, utilisé pour analyser des composés organiques.

- Prolog : Langage de programmation basé sur la logique, souvent utilisé pour les systèmes symboliques.

- ELIZA : Un des premiers chatbots, basé sur des règles pour simuler une conversation psychothérapeutique.

2. Machine Learning (ML)

- Scikit-learn : Librairie Python pour l’apprentissage automatique (classification, régression, clustering).

- XGBoost : Outil spécialisé dans les algorithmes d’apprentissage supervisé rapide et performant.

- TensorFlow : Framework open-source de Google pour développer des modèles de ML.

- H2O.ai : Plateforme de ML automatisée pour analyser des données rapidement.

3. Deep Learning (DL)

- PyTorch : Framework flexible et populaire pour construire des réseaux de neurones profonds.

- Keras : Interface haut-niveau pour TensorFlow, utilisée pour développer rapidement des modèles de DL.

- Hugging Face : Bibliothèque dédiée aux Transformers pour le NLP, avec une interface simple d’utilisation.

- DeepMind (AlphaGo) : Modèle de DL qui a surpassé les humains dans des jeux complexes comme le Go.

4. Modèles de langage (LLM)

- ChatGPT (OpenAI) : Basé sur GPT, pour des conversations et de la génération de contenu.

- BERT (Google) : Modèle pour la compréhension de texte et les moteurs de recherche.

- Claude (Anthropic) : Modèle de langage centré sur la sécurité et la compréhension contextuelle.

- DALL·E : Modèle génératif pour transformer du texte en images.

Résumé rapide :

| Type | Outils / Services |

|---|---|

| IA Symbolique | MYCIN, Prolog, ELIZA |

| Machine Learning | Scikit-learn, XGBoost, TensorFlow, H2O.ai |

| Deep Learning | PyTorch, Keras, Hugging Face, AlphaGo |

| LLM | ChatGPT, BERT, Claude, DALL·E |